Ohrožení epistemické bezpečnosti

Epistemická bezpečnost je schopnost rozlišovat fakta od fikce, rozpoznávat nepodložená tvrzení, nedůvěryhodné informační zdroje a klamavý či zavádějící obsah. Moderní informační technologie zásadně zjednodušují tvorbu a distribuci informací, což má i své stinné stránky.

Zde jsou čtyři hlavní mechanismy ohrožení epistemické bezpečnosti, jak je popsali autoři studie o epistemické bezpečnosti z Institutu Alana Turinga:

🗣️ Dezinformátoři: je stále snazší zasahovat do rozhodovacích procesů prostřednictvím dezinformací, manipulací a misinterpretací.

🙇♂️ Nedostatek pozornosti: s nadměrnou hojností informací je stále těžší udržet pozornost příjemců. To vede k tzv. ekonomice pozornosti, kde zápas o pozornost často způsobuje kompromisy mezi pravdivostí a poutavostí informací.

👨👩👦 Izolované komunity: rychle vznikají a přetrvávají izolované komunity, které odmítají informace zpochybňující jejich názory. Silná vnitroskupinová identita vede k větší polarizaci mezi skupinami.

🙅♂️ Narušení důvěry: technologie zprostředkovávající a produkující informace ztěžují hodnocení důvěryhodnosti jednotlivých informačních zdrojů.

S nástupem velkých jazykových modelů a možných nových tranformativních AI mohou být tyto mechanismy ještě umocněny. V budoucnu může být naše digitální stopa zneužívána k psychologickému profilování a generování manipulativních informací na míru. Mohli bychom se tak ocitnout ve světě bez demokracie, kde totalitní režimy kontrolují tok informací a používají techniky masové manipulace. Pojďme se na všechny čtyři výše zmíněné mechanismy podívat zblízka.

Narušení důvěry

Moderní informační technologie a rychlý nástup stále výkonnějších AI systémů mnohdy ztěžují rozpoznávání falešných informací a důvěryhodných zdrojů.

V nedávné době se na českých sociálních sítích objevilo deep fake video s autenticky vypadajícím i znějícím prezidentem Petrem Pavlem, které propaguje pochybnou aplikaci, která slibuje rychlé zbohatnutí. Zde je odkaz na rozbor na webu hn.cz.

AI systémy pro práci s přirozeným jazykem mohou být použity k identifikaci a generování řečových vzorů, na které uživatelé reagují pozitivně, s cílem získat důvěru bez ohledu na pravdivost obsahu. Autoři studie z Alan Turing Institute navrhují výzkum nových metod pro ověřování informací. Například certifikaci organizací jako epistemicky zodpovědných informační zdrojů. Je ovšem možné, že cílené dezinformace by podrývaly důvěryhodnost takové certifikace.

Existující postupy zahrnují vědeckou replikaci, novinářské ověřování faktů nebo důkazní břemeno v trestním řízení. To jsou ovšem zdlouhavé procesy, které není snadné uplatnit na velké množství informací, kterým jsme jako jednotlivci denně vystavováni.

Dezinformace

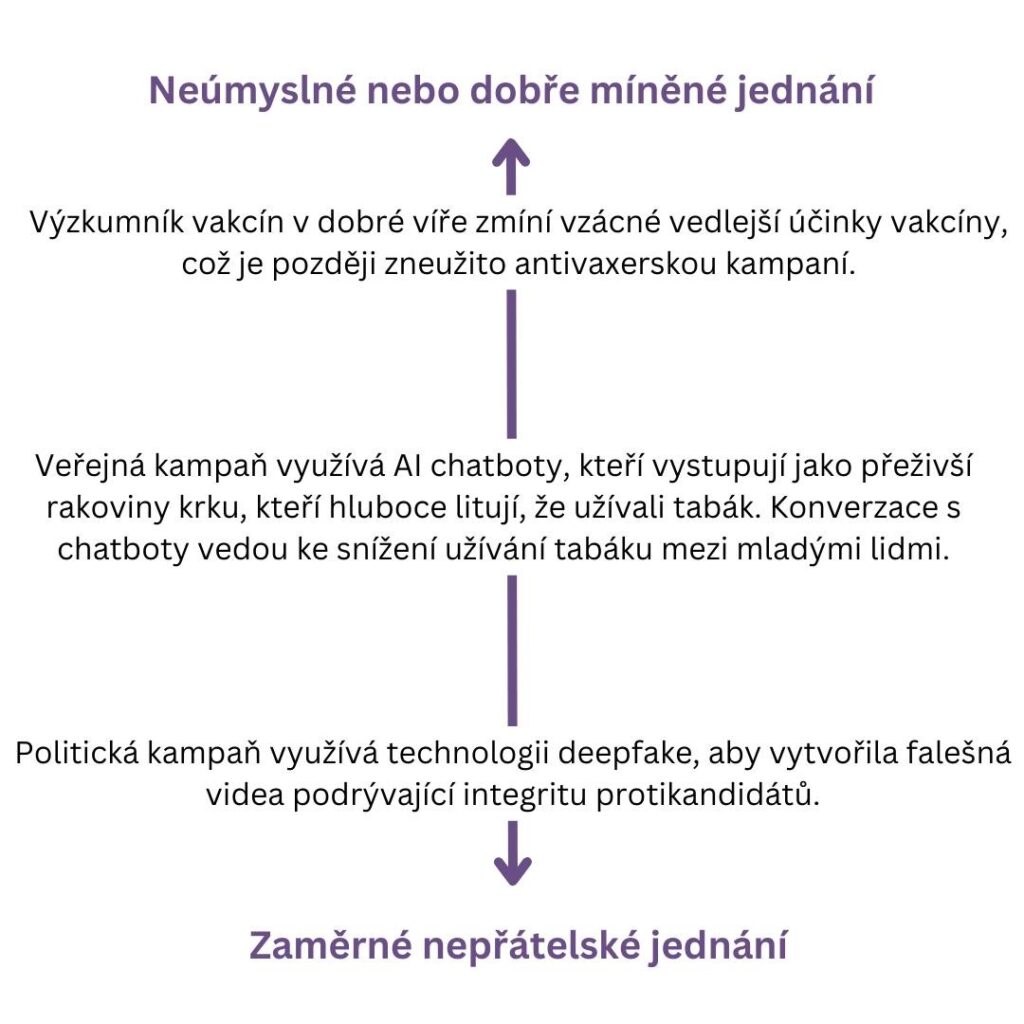

Pokud je informacemi manipulováno s úmyslem oklamat, uvést v omyl nebo zmást, považuje se to za „nepřátelský útok“ na procesy získávání a šíření znalostí. K podobnému výsledku může ovšem vést i dobře míněné nebo neúmyslné chování. Několik příkladů najdete na obrázku.

Středoevropská observatoř digitálních médií (CEDMO) dělá pravidelné výzkumy, kde zjišťuje, kterým nepravdivým informacím o aktuálním dění Češi a Češky nejčastěji věří. Zde je odkaz na článek od iRozhlas, který výzkum rozebírá.

Zde je výčet nejčastějších nepravdivých informací, kterým Češi a Češky věří. Čísla označují, kolik procent respondentů, kteří informaci zaznamenali, jí spíše nebo zcela věří:

1️⃣ Zkreslené údaje o počtech nepracujících uprchlíků z Ukrajiny: 54 %

2️⃣ Nebezpečnost ukrajinského obilí kvůli pesticidům: 52 %

3️⃣ Zavádění uhlíkové daně na nemovitosti Evropskou unií: 51 %

4️⃣ Zkreslená statistika míry kriminality mezi Ukrajinci v ČR: 48 %

5️⃣ Zvyšování DPH na léky kvůli výdajům na obranu: 48 %

Autoři studie z Alan Turing Institute navrhují postihy za vědomé šíření nepravdivých informací a absenci minimálních fact-checkingových opatření. Navrhují také zavedení tzv. red-teamingových strategií, kdy jsou různé narativy předem zkoumány z pohledu dezinformátorů, aby bylo možné zavést preventivní opatření.

Ekonomika pozornosti a doporučovací systémy

Narůstající množství informací, kterým jsme vystaveni, dalo vzniknout tzv. ekonomice pozornosti, kde spolu různé zdroje informací soutěží o naši limitovanou pozornost. Tvůrce obsahu to vede k tomu, aby tvořili obsah, který je senzační, snadno a rychle stravitelný a emočně nabitý. Méně zdrojů mohou věnovat na strategie, jejichž cílem je zajistit šíření spolehlivých informací.

Strategie upoutávající pozornost podporují vznik tzv. echo chambers, kde lidé konzumují informace, které posilují jejich stávající názory. To vede k polarizaci společnosti. Významný podíl na tomto jevu mají doporučovací systémy, kde se algoritmy učí, jaký typ obsahu u nás vyvolá kýženou reakci, a následně nám takový obsah častěji doporučují. Typickými příklady může být Facebook, YouTube nebo Netflix.

Podle autorů návrhu pro výzkum v této oblasti lze systémy zlepšit následujícími způsoby:

🗣️ Systémy by mohly s uživateli aktivně komunikovat, aby si ujasnily jejich opravdové preference a dlouhodobé cíle.

💭 Optimalizovat obsah podle toho, co by uživatelé chtěli udělat, kdyby měli více informací a více času na rozmyšlenou.

💢 Systémy by mohly filtrovat obsah, který pravděpodobně bude u uživatelů vyvolávat hněv, což ovšem samo o sobě může být v některých případech nežádoucí.

Polarizace společnosti

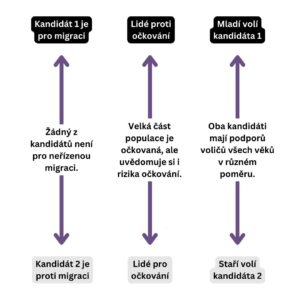

Komunity mimo jiné vznikají na základě sdílených přesvědčení. Pocit sounáležitosti se skupinou může vést k tzv. syndromu skupinového myšlení (groupthink), případně k názorové konformitě se skupinou (conformity bias). V extrémním případě to může vést k radikalizaci, kdy se původně mírně odlišný názor přetvoří v silný postoj. V rámci hájení svého názoru při konfrontaci se skupinami, které zastávají opačný názor, se intenzita postoje dále utvrzuje. Svět přitom není černobílý a pravda se často neskrývá v žádném extrému.

V dobře fungujících komunitách mohou technologie pomoci zkvalitnit debatu a názorovou pluralitu. Příkladem může být web LessWrong.com, kde si uživatelé zakládají na racionalitě a transparentní argumentaci. Naopak v epistemicky slabších komunitách technologie mohou vést k syndromu skupinového myšlení, groupthinku, radikalizaci a polarizaci nebo k umlčování protichůdných názorů.